L’ère de l’AGI multimodale: une rupture dans la création et la perception vidéo

En 2024, l’accélération des développements en intelligence artificielle générale multimodale marque un véritable tournant. Contrairement à une IA classique spécialisée – par exemple dans la reconnaissance d’images ou la génération de texte – une AGI multimodale intègre et traite simultanément des données vidéo, audio, textuelles et sensorielles. Cela lui permet, par apprentissage transversal, de comprendre et de générer de nouveaux contenus par fusion de sources (par exemple, créer une scène entière à partir d’une description manuscrite, ou synchroniser voix et gestes dans des créations virtuelles complexes).

Concrètement, des modèles comme Google Gemini, OpenAI GPT-4 Turbo ou Meta ImageBind démontrent déjà une capacité à orchestrer plusieurs flux de données: analyse vidéo frame par frame, restitution du contexte auditif, reproduction de micro-expressions humaines. Ces architectures d’AGI permettent la génération de contenus vidéo et audio si réalistes que la frontière entre virtuel et réel s’estompe. Cela va bien au-delà des simples deepfakes traditionnels, rendant la détection humaine très difficile.

Pour approfondir le sujet, voyez l’analyse prospective de « modèles de langage vidéo« . Cette révolution appelle une réflexion profonde sur la IAG, son rôle dans la création de réalités virtuelles et les questions éthiques découlant de ces capacités inédites.

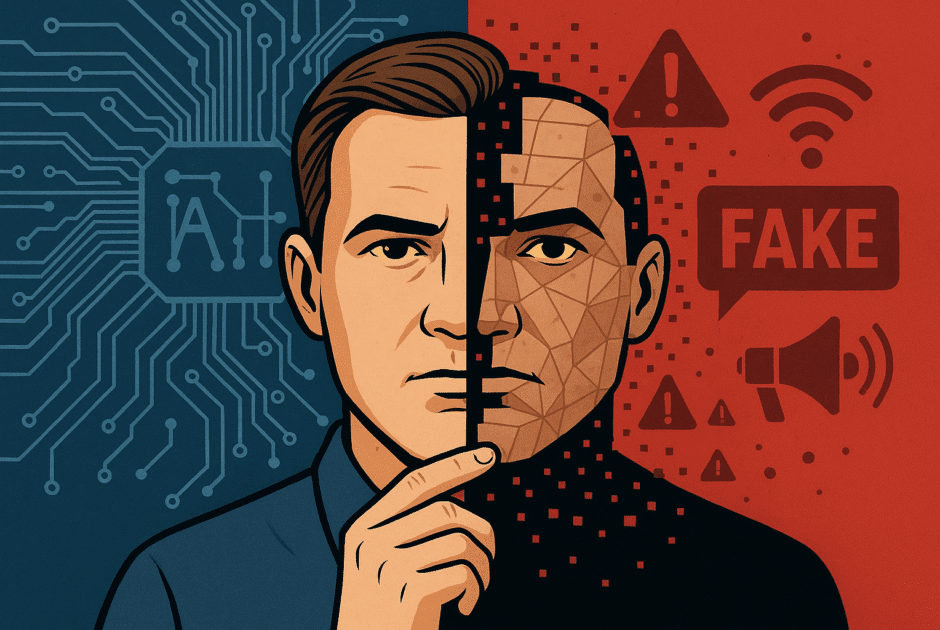

Quand la vidéo devient une illusion parfaite : la montée des deepfakes cognitifs

L’arrivée des deepfakes cognitifs portés par l’ia générale marque un changement de paradigme. Ces vidéos, générées par des modèles d’intelligence artificielle générale multimodale, ne se contentent plus d’imiter le visuel ou la voix – elles manipulent la narration, l’intonation, le langage corporel, et s’adaptent même à l’auditoire pour induire des réactions cognitives spécifiques.

Exemples concrets: la génération de fausses preuves vidéo parfaitement crédibles lors de procès ou d’élections, la création de témoignages simulés de personnalités publiques, ou l’orchestration de scènes de panique injustifiées lors d’événements géopolitiques. Des modèles comme Sora (OpenAI), Runway Gen-2 ou Synthesia illustrent la capacité à produire des séquences indistinguables de la réalité, même pour un œil expert.

Ces deepfakes cognitifs exploitent la perception humaine à un niveau profond : ils intègrent des micro-variations émotionnelles et des contextes adaptés à la culture ou à l’actualité, ce qui brouille la frontière entre réel et fiction. Le rôle de l’AGI dans la désinformation devient central, soulignant l’enjeu de l’AGI dans la manipulation de masse et la nécessité urgente de nouvelles méthodes de vérification.

Désinformation immersive: nouveaux risques et impacts pour la société

L’immersion offerte par les deepfakes cognitifs propulsés par l’IAG bouleverse la donne sociétale. Là où les » fake news » classiques reposaient sur le texte ou des images peu crédibles, la vidéo ultra-réaliste impacte toutes les sphères : politique, sécurité, économie, science. Par exemple, lors d’élections, de fausses vidéos d’hommes politiques incitant à la violence peuvent surgir et déstabiliser le débat démocratique en quelques heures.

- En politique: campagnes de désinformation ciblées, simulation de discours officiels, manipulation d’opinions publiques.

- En économie: diffusion de fausses annonces de PDG entraînant des fluctuations boursières ou fraudes massives.

- Dans la science: falsification de déclarations d’experts ou d’expériences scientifiques, semant confusion sur des sujets sanitaires clés.

L’aspect immersif est renforcé par la capacité de l’intelligence artificielle à personnaliser les messages selon les biais cognitifs du spectateur, exploitant les avancées en neurosciences et psychologie sociale. Ainsi, la population est exposée à un risque accru de manipulation émotionnelle et d’ingénierie sociale automatisée. Pour une mise en perspective plus large de ces mécanismes, voir l’article « AGI modère le web« .

Les limites de la détection et la course à l’armement cognitif

Malgré la multiplication des outils de détection, l’intelligence artificielle générative surpasse déjà nombre d’entre eux. Les technologies classiques se basent sur la détection d’artefacts vidéo, d’incohérences audio ou d’empreintes numériques. Or, les dernières architectures d’AGI affinent leur rendu jusqu’à effacer presque tous ces indices. Les benchmarks publics comme le Deepfake Detection Challenge sont régulièrement dépassés par de nouveaux modèles de génération.

Des projets open source (comme DeepFaceLab, FaceForensics++) et propriétaires (Microsoft Video Authenticator, Google DeepMind SynthID) se livrent une véritable course à l’armement algorithmique. Cette compétition complexe soulève des enjeux éthiques : faut-il publier ces outils et benchmarks ouvertement au risque d’alimenter aussi les faussaires? Les chercheurs s’interrogent désormais sur la nécessité d’alliances internationales et de normes partagées dans la lutte contre la manipulation cognitive générée par l’intelligence artificielle générale.

Pour comprendre la dimension matérielle de cette bataille, consultez « la bataille hardware pour l’AGI« .

Conclusion – Anticiper la déferlante: quelles ripostes et vigilance collective face à l’AGI faussaire?

L’avènement des deepfakes cognitifs générés par l’intelligence artificielle générale impose une adaptation de la société à grande échelle. Au-delà de la course algorithmique, l’enjeu crucial est la construction d’une résilience cognitive collective. Cela passe par une éducation renforcée à l’esprit critique, des outils de détection intégrables par tous, et un engagement fort de la recherche dans le développement de standards transparents.

La cyberdéfense doit évoluer: anticipation des menaces par surveillance active, algorithmes ouverts auditables, coopération internationale et partage des alertes. Le rôle de la société civile est tout aussi vital: vigilance, formation et capacité à douter des évidences médiatiques. Les acteurs clés – médias, plateformes, chercheurs, éducateurs – doivent collaborer pour préserver l’intégrité de l’information et protéger la démocratie face à la sophistication de l’AGI faussaire.

Dans ce contexte, le site ia générale s’engage à fournir ressources et analyses pour comprendre et anticiper ces bouleversements.