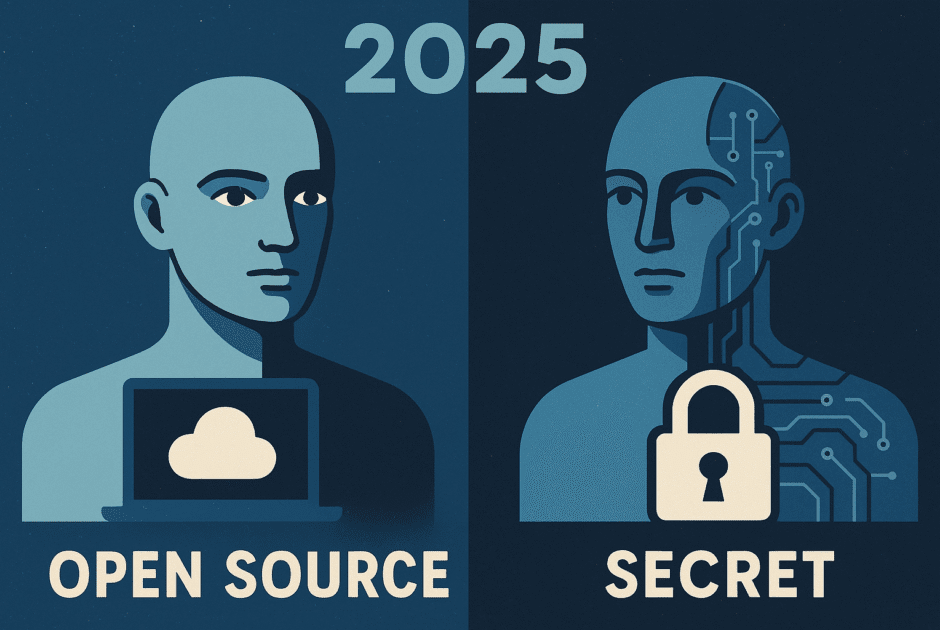

De la promesse à l’inquiétude : pourquoi l’ouverture des modèles AGI fait débat

L’année 2025 marque un tournant dans le débat sur l’ouverture ou la fermeture des modèles d’intelligence artificielle générale (AGI). Historiquement, la promesse de l’open source dans l’IA a permis des avancées grâce à la transparence et la collaboration globale. Des projets comme GPT-Neo ou LAION incarnent cette tradition d’ouverture.

Cependant, face à la montée en puissance de l’IA généraliste, de plus en plus de laboratoires optent pour le secret et la privatisation de leurs découvertes. OpenAI, autrefois chantre de l’open source, réserve désormais l’accès à ses modèles les plus avancés tels que GPT-5 à des collaborateurs triés sur le volet ou à des institutions sous contrats stricts. DeepMind (Google) et Anthropic suivent cette tendance, invoquant des inquiétudes de cybersécurité et le risque de détournement malveillant.

Des voix influentes, comme Sam Altman et Yann LeCun, se sont exprimées. Altman prône une approche progressive et contrôlée, tandis que LeCun plaide pour la science ouverte mais avec des garde-fous adaptés. Les institutions telles que l’UNESCO alertent aussi sur la nécessité d’encadrer le développement de l’AGI afin d’éviter un scénario de fuite anarchique du code ou de prolifération incontrôlée.

Ce clivage s’accentue alors que la société réalise qu’un modèle AGI ouvert, outre ses promesses, multiplie les risques de mauvaise utilisation – cyberattaques, manipulations, perte de contrôle. La question de l’équilibre entre innovation partagée et sécurité mondiale reste donc plus brûlante que jamais.

Cybersécurité et AGI : les risques concrets d’une fuite ou d’un détournement

Les risques associés à la fuite ou au détournement d’un modèle AGI ne sont plus théoriques. En 2024, plusieurs incidents ont frappé le secteur, illustrant l’émergence de ces nouvelles menaces. Par exemple, une équipe de hackers éthiques affiliée à l’université de Stanford a simulé l’exfiltration d’un artefact de modèle via une attaque de supply chain, démontrant comment une version non patchée d’un LLM pouvait servir à générer des malwares polymorphes indétectables.

Par ailleurs, le ransomware connu sous le nom de « GhostWriter AGI » a tenté, en mai 2025, d’utiliser un agent IA autonome entraîné sur des données génératives pour infiltrer le réseau de plusieurs entreprises de cybersécurité, créant une onde de choc dans l’écosystème tech. Même si ces attaques restent expérimentales, elles soulignent la vulnérabilité accrue des acteurs du secteur : si du code AGI tombe entre de mauvaises mains, les conséquences pour la sécurité des données, la stabilité des systèmes sociaux et la confiance dans la technologie pourraient être majeures.

Les spécialistes du CERT-EU et du MIT CSAIL recommandent désormais des audits croisés permanents et l’implémentation de systèmes de « kill switch » algorithmique pour réduire le risque de perte de contrôle. La publication d’analyses de risques par des groupes comme l’EFF ou l’AI Now Institute alimente quant à elle le débat public sur la légitimité d’ouvrir des modèles aussi puissants sans garanties drastiques.

Collaborer ou verrouiller ? Les alliances inédites et stratégies émergentes depuis mai 2025

Depuis mai 2025, la scène de l’IA assiste à un bouleversement des alliances et à la création de nouveaux modèles de collaboration. Alors que certains laboratoires comme OpenAI, Microsoft et Meta nouent des accords de non-divulgation étendus pour protéger leurs avancées en AGI, d’autres acteurs innovent en formant des consortiums pour mutualiser la recherche… tout en verrouillant les accès aux modèles.

Parmi les initiatives marquantes figurent le « PACT for Safe Superintelligence » lancé par plusieurs GAFAM, visant à établir des standards communs de cybersécurité et à partager les alertes sur d’éventuelles vulnérabilités critiques des modèles AGI. Dans un autre registre, des start-ups européennes comme Aleph Alpha et Mistral AI, conscientes de l’avance américaine, militent pour une alliance « souveraine » afin d’assurer une indépendance stratégique tout en gardant la maîtrise éthique.

Des stratégies hybrides se développent également : certains laboratoires proposent d’ouvrir partiellement leur code à des chercheurs académiques, sous réserve d’accords stricts. Cette dynamique d’alliances inédites et de stratégies croisées façonne un nouveau jeu de pouvoir, dont l’objectif est autant la maîtrise technologique que la gestion sécurisée de la course à la superintelligence (lire la synthèse sur Wired).

Conséquences pour la société et l’innovation : ouvrir le code ou renforcer les murs ?

Le débat sur l’ouverture ou la fermeture des modèles AGI a des conséquences directes sur la société, la recherche et l’écosystème de l’innovation. Les défenseurs de l’open source, dont de nombreux chercheurs et acteurs de la société civile (comme Creative Commons ou Mozilla), estiment qu’une ouverture contrôlée favoriserait la diversité des innovations, détecterait plus vite les biais et résorberait les asymétries de pouvoir entre grandes entreprises et petits acteurs.

À l’inverse, les industriels du secteur mettent en avant le devoir de responsabilité – ouvrir totalement le code d’une AGI ou d’une superintelligence artificielle (ASI) pourrait catalyser une compétition incontrôlable, déstabiliser les marchés et faciliter des usages antisociaux ou même criminels. Selon un rapport de l’OECD AI Policy Observatory, la fracture entre innovation ouverte et secret industriel se creuse, menaçant l’interopérabilité des systèmes et l’avancée collective des connaissances.

Pour répondre à ce dilemme, plusieurs voies s’esquissent : des licences d’accès graduel, une gouvernance multipartite associant société civile, états et secteur privé, ou encore des « salles blanches » numériques dans lesquelles les chercheurs pourraient travailler sans possibilité de fuite du code. Ces solutions balancent entre transparence, innovation et protection contre les dérives.

Conclusion : Vers un nouvel équilibre mondial de la confiance en AGI ?

Alors que l’AGI se profile comme l’un des défis majeurs de la décennie, la question de son ouverture ou de son verrouillage pose désormais celle de la confiance globale. On voit émerger de nouveaux modèles de gouvernance, inspirés à la fois des régulations du nucléaire et de l’éthique numérique, appelant à la mise en place d’instances de contrôle indépendantes et de normes internationales.

La discussion ne fait que commencer – et les choix pris en 2025 auront des répercussions profondes sur l’innovation, la sécurité et les libertés pour les années à venir. La société civile, les industriels et les pouvoirs publics sont appelés à s’exprimer, entre vigilance et optimisme. La création d’un équilibre mondial durable dans la gouvernance de l’AGI passerait peut-être, comme le suggèrent des experts du Future of Life Institute, par une alliance inédite entre ouverture encourageant la recherche et dispositifs stricts de sécurisation. La réflexion collective reste donc urgente et ouverte à tous les contributeurs.