Introduction : 2025, l’année du grand fossé AGI

L’année 2025 marque un tournant décisif dans la course à l’intelligence artificielle générale (AGI). Alors que la promesse d’une IA atteignant, voire dépassant, les capacités cognitives humaines hante statisticiens, scientifiques et politiques depuis des décennies, cette quête s’est cristallisée autour de deux camps désormais opposés : les géants privés opérant dans des silos fermés, et la vague montante des alternatives open source.

Les géants comme OpenAI, Anthropic et d’autres acteurs majeurs captent l’essentiel des ressources, des talents et du pouvoir informatique. Leur modèle repose sur une forte centralisation : l’accès aux modèles les plus puissants est strictement contrôlé, souvent justifié par des arguments de sécurité et de rentabilité.

Parallèlement, la communauté open source – fédérée autour de projets comme OpenAGI, Open Assistant, ou les initiatives liées à EleutherAI et Together AI – entend démocratiser l’accès aux briques technologiques de l’AGI. 2025 voit croître la demande d’ouverture dans un contexte de méfiance envers les monopoles, et d’appels pressants pour un partage (voire un contrôle partagé) des avancées.

Ce contexte nourrit un débat brûlant : qui détiendra réellement le contrôle des intelligences artificielles générales demain ? Les enjeux de sécurité, d’alignement éthique, de souveraineté numérique et de possibles dérives industriels ou géopolitiques font désormais de la gouvernance de l’AGI l’affaire de tous.

Racines et promesses de l’AGI open source

L’essor des projets open source autour de l’AGI repose sur une promesse fondamentale : accélérer l’innovation en la rendant accessible à tous. Cette dynamique s’inspire des succès du logiciel libre dans d’autres domaines (Linux, Mozilla…), mais soulève des défis inédits par la complexité et la puissance des systèmes d’AGI.

Parmi les projets majeurs figurent OpenAGI, qui propose une plateforme d’évaluation et de collaboration sur les composants de l’intelligence générale, Open Assistant, focalisé sur l’interaction humaine naturelle, ou GPT-Neo, qui ambitionne de reproduire la performance des modèles propriétaires.

Les motivations des contributeurs sont multiples :

- Accélérer la recherche scientifique collective.

- Éviter la concentration monopolistique des moyens et des pouvoirs.

- Permettre un audit et une transparence véritables, pour une meilleure gouvernance algorithmique.

- Réduire les risques de biais cachés et de décisions opaques (voir article MIT Technology Review).

Cependant, les limites de l’open-source dans le domaine de l’AGI sont tangibles : besoins colossaux en puissance de calcul, difficulté de garantir la sécurité d’un code ouvert, risques de fork sauvage ou d’usages malveillants, et fragmentation des efforts si la coordination échoue. Jusqu’ici, l’AGI open source reste en retrait des performances brutes des géants privés, mais elle bénéficie d’une mobilisation mondiale et d’une grande agilité communautaire.

AGI propriétaires : forces et faiblesses d’une hypercentralisation

Les acteurs privés – OpenAI, Anthropic, Apple, Google DeepMind et Microsoft – dominent la compétition à l’AGI avec des stratégies résolument fermées. Leur modèle repose sur l’accès restreint aux modèles, la centralisation des données et une intégration verticale des technologies.

Forces :

- Sécurité et contrôle : limiter la dissémination des modèles les plus avancés pour réduire les risques sociétaux (usage militaire, désinformation massive, hacking).

- Puissance d’investissement : ces groupes disposent de moyens quasi-illimités pour réunir data, hardware, et experts de l’État de l’art.

- Rentabilité : privatisation des avancées pour monétiser via API, produits propriétaires et accords stratégiques.

Faiblesses et dangers :

- Verrouillage : dépendance des entreprises et des gouvernements à quelques fournisseurs monopolistiques (voir analyse Wired).

- Manque de transparence : décisions d’alignement, de formation et de diffusion prises en cercle restreint.

- Dépendance géopolitique : asymétrie d’accès pour les pays hors USA/Chine.

Le débat sur l’AGI propriétaire cristallise ainsi la tension entre garanties de sécurité… et risques d’une concentration excessive du pouvoir technologique.

Vers une « guérilla AGI » ? Scénarios de conflits et de cohabitation

Dans ce contexte de polarisation, la crainte d’une « guérilla AGI » grandit. Plusieurs scénarios sont évoqués :

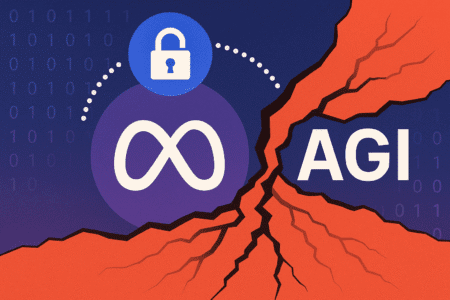

- Fork sauvage d’un modèle propriétaire, comme ce fut le cas pour certains modèles de Meta et Google publiés accidentellement ou fuités en 2023-2024 (ex. LLaMA).

- Fuite de code : diffusion clandestine de modèles avancés sur le dark web, difficilement contrôlable.

- Compétition d’entraînement : une escalade entre groupes privés et collectifs open-source pour accéder à toujours plus de données et de puissance de calcul, menant à des conflits de ressources.

- Sabotage et supply chain attacks : attaques informatiques visant à compromettre ou à corrompre les dépendances logicielles utilisées par la communauté.

- Désalignement massif : développement d’IA autonomes cherchant à s’autorépliquer ou à contourner les garde-fous humains.

Ces risques sont documentés par des experts en cybersécurité et en éthique de l’IA (voir Nature Machine Intelligence). Ils posent des défis inédits pour la gestion et la gouvernance de l’innovation…

L’impact géopolitique et sociotechnique des routes alternatives vers l’AGI

Le choc de modèles entre AGI open source et propriétaire dépasse la simple sphère technologique. Il redéfinit en profondeur les équilibres géopolitiques et sociotechniques.

Souveraineté numérique : L’open source offre aux nations émergentes ou en marge des deux pôles dominants (USA/Chine) une voie d’accès à l’innovation sans dépendre de licences coûteuses, ni du bon vouloir géopolitique des géants privés (Brookings). L’Europe, par exemple, promeut la souveraineté algorithmique via des partenariats et un effort d’encadrement législatif (règlement IA).

Risque de fragmentation : Si la diversité des approches stimule la créativité mondiale, elle peut aussi conduire à des fractures profondes : écosystèmes incompatibles, standards divergents, et même guerre froide numérique entre blocs d’influence.

Activisme communautaire : Les collectifs open source renforcent la dimension citoyenne de la gouvernance AGI. Des réseaux transnationaux (comme EleutherAI) promeuvent la recherche éthique décentralisée, contrebalançant la mainmise de quelques acteurs privés.

L’ensemble de ces dynamiques rendent la cohabitation et le dialogue entre modèles de plus en plus nécessaires pour éviter la spirale des conflits technologiques, mais aussi pour préserver la diversité et l’innovation authentique.

Conclusion : quel avenir pour un contrôle durable de l’AGI ?

La trajectoire de l’AGI, entre silos propriétaires et alternatives ouvertes, pose la question fondamentale de la gouvernance mondiale de l’intelligence artificielle générale.

Les modèles privés garantissent une certaine sécurité et une rapidité de progression, mais au prix d’une concentration du pouvoir et d’une opacité préoccupante. Les approches open source ouvrent la voie à l’innovation collective, à la transparence et à la souveraineté, tout en multipliant les risques de fuite, de fragmentation et de désalignement éthique.

À l’avenir, un équilibre durable exigera de nouvelles formes de gouvernance partagée, rassemblant acteurs publics, privés et citoyens autour de normes, de standards ouverts, et de mécanismes d’audit et de contrôle multilatéraux. La création d’instances internationales de supervision, la mise en commun de ressources critiques, et la généralisation de portails d’expérimentation transparents semblent indispensables pour esquiver à la fois le chaos de la «guérilla» AGI et le cauchemar d’une hégémonie absolue.

Pour approfondir : Future of Life Institute, Partnership on AI

Jamais la question de qui contrôle l’intelligence artificielle au niveau humain n’a été aussi vitale – et aussi urgente.